Découvertes et réalisations de la physique du 21e siècle. Les découvertes scientifiques les plus importantes du 21e siècle

L'année écoulée a été marquée par une série de percées dans le domaine de la physique théorique et expérimentale. Certains scientifiques pensent qu'il a généralement marqué un tournant - ses découvertes ont amené la science mondiale à un nouveau niveau. Mais quand même, lequel d'entre eux s'est avéré être le plus important ? La revue scientifique faisant autorité Physics World propose sa version du top 10 dans le domaine de la physique.

Au première place la publication, bien sûr, a mis en scène la détection d'une particule similaire au boson de Higgs par les collaborations ATLAS et CMS au Large Hadron Collider (LHC). Rappelons que la découverte de la particule prédite il y a près d'un demi-siècle aurait dû compléter la confirmation expérimentale du Modèle Standard. C'est pourquoi de nombreux scientifiques ont considéré la détection du boson insaisissable comme une percée majeure dans la physique XXI siècle.

Le boson de Higgs était si important pour le scientifique car son champ permet d'expliquer comment la symétrie électrofaible a été brisée immédiatement après le Big Bang, après quoi les particules élémentaires ont soudainement acquis une masse. Paradoxalement, l'un des mystères les plus importants pour les expérimentateurs n'est resté longtemps que la masse de ce boson, puisque le Modèle Standard ne peut la prédire. Nous avons dû agir par essais et erreurs, mais au final, deux expériences au LHC indépendamment l'une de l'autre ont découvert une particule d'une masse d'environ 125 GeV/s². De plus, la fiabilité de cet événement est suffisamment élevée.

Il convient de noter qu'une petite mouche dans la pommade s'est néanmoins glissée dans le baril de miel - jusqu'à présent, tout le monde n'est pas sûr que le boson trouvé par les physiciens soit Higgs. Ainsi, on ne sait toujours pas quel est le spin de cette nouvelle particule. Selon le modèle standard, il devrait être égal à zéro, mais il est possible qu'il soit égal à 2 (la variante avec un a déjà été exclue). Les deux collaborations pensent que ce problème peut être résolu en analysant les données disponibles. Joe Incandela de CMS prédit que des mesures de spin avec un niveau de confiance de 3-4σ pourraient être disponibles dès la mi-2013.

De plus, il existe des doutes sur un certain nombre de canaux de désintégration des particules - dans certains cas, ce boson ne s'est pas désintégré de la manière prédite par le même modèle standard. Cependant, les collaborateurs pensent que cela peut également être clarifié en faisant une analyse plus précise des résultats. Soit dit en passant, lors de la conférence de novembre au Japon, le personnel du LHC a fourni les données de l'analyse de nouvelles collisions d'une énergie de 8 TeV, qui ont été faites après l'annonce de juillet. Et ce qui s'est passé en conséquence plaide en faveur du fait que le boson de Higgs a été trouvé en été, et non une autre particule.

Cependant, même s'il ne s'agit pas du même boson, selon Physics World, les collaborations ATLAS et CMS méritent un prix. Car dans l'histoire de la physique, il n'y a pas encore eu d'expériences à si grande échelle dans lesquelles des milliers de personnes auraient été impliquées et qui auraient duré deux décennies. Cependant, il est possible qu'une telle récompense soit un repos long bien mérité. Maintenant, les collisions de protons se sont arrêtées, et pendant longtemps - comme vous pouvez le voir, même si la fameuse "fin du monde" était une réalité, alors le collisionneur ne serait certainement pas à blâmer pour cela, car à ce moment-là il a été tourné la même énergie réalisera plusieurs expériences sur la collision de protons avec des ions plomb, puis l'accélérateur sera arrêté pendant deux ans pour modernisation, afin de le redémarrer ensuite, portant l'énergie des expériences à 13 TeV.

La deuxième place le magazine a été remis à un groupe de scientifiques des universités de technologie de Delft et d'Eindhoven (Pays-Bas) dirigé par Leo Kouvenhoven, qui ont été les premiers cette année à remarquer des signes des fermions de Majorana jusque-là insaisissables dans un solide. Ces drôles de particules, dont l'existence a été prédite en 1937 par le physicien Ettore Majorana, sont intéressantes car elles peuvent agir simultanément comme leurs propres antiparticules. On suppose également que les fermions de Majorana pourraient faire partie de la mystérieuse matière noire. Il n'est pas surprenant que les scientifiques s'attendaient à leur découverte expérimentale pas moins que la découverte du boson de Higgs.

Au troisième place la revue a publié les travaux de physiciens de la collaboration BaBar au collisionneur PEP-II du SLAC National Accelerator Laboratory (États-Unis). Et ce qui est le plus intéressant, ces scientifiques ont à nouveau confirmé expérimentalement la prédiction faite il y a 50 ans - ils ont prouvé que lorsque les mésons B se désintègrent, la symétrie T est rompue (c'est le nom de la relation entre le processus direct et inverse dans les phénomènes réversibles ). En conséquence, les chercheurs ont découvert que lors des transitions entre les états quantiques des mésons B0, leur vitesse varie.

Au quatrième place vérifier à nouveau l'ancienne prédiction. Il y a encore 40 ans, les physiciens soviétiques Rashid Sunyaev et Yakov Zeldovich ont calculé que le mouvement des amas de galaxies lointaines peut être observé en mesurant un petit décalage de la température du rayonnement relique. Et seulement cette année, Nick Hand de l'Université de Californie à Berkeley (USA), son collègue et l'Atacama Cosmology Telescope, un télescope de six mètres, ont réussi à le mettre en pratique dans le cadre de l'étude spectroscopique des oscillations baryoniques.

Cinquième place a repris les recherches du groupe d'Allard Mosca du MESA + Institute for Nanotechnology et de l'Université de Twente (Pays-Bas). Les scientifiques ont suggéré nouvelle façonétudes des processus se produisant dans les organismes des êtres vivants, ce qui est moins nocif et plus précis que la radiographie connue de tous. Les scientifiques ont réussi, en utilisant l'effet du speckle laser (c'est le nom d'un motif d'interférence aléatoire formé par l'interférence mutuelle d'ondes cohérentes avec des déphasages aléatoires et un ensemble aléatoire d'intensités), à voir des objets fluorescents microscopiques à travers plusieurs millimètres d'un matériau opaque . Inutile de dire qu'une technologie similaire avait également été prédite plusieurs décennies plus tôt.

Au sixième place Mark Oxborrow du National Physical Laboratory, Jonathan Breeze et Neil Alford de l'Imperial College de Londres (Royaume-Uni). Ils ont réussi à construire ce dont ils rêvaient aussi depuis de nombreuses années : un maser (un générateur quantique qui émet des ondes électromagnétiques cohérentes de l'ordre du centimètre), capable de fonctionner à température ambiante. Jusqu'à présent, ces appareils devaient être refroidis à des températures extrêmement basses à l'aide d'hélium liquide, ce qui les rendait peu rentables pour un usage commercial. Et maintenant, les masers peuvent être utilisés dans les télécommunications et les systèmes d'imagerie ultra-précis.

Septième place décerné à juste titre à un groupe de physiciens d'Allemagne et de France qui ont pu établir un lien entre la thermodynamique et la théorie de l'information. En 1961, Rolf Landauer affirmait que l'effacement d'informations s'accompagnait d'une dissipation thermique. Et cette année, cette hypothèse a été confirmée expérimentalement par les scientifiques Antoine Beru, Artak Arakelyan, Artem Petrosyan, Sergio Silliberto, Raul Dellinschneider et Eric Lutz.

Les physiciens autrichiens Anton Zeilinger, Robert Fickler et leurs collègues de l'Université de Vienne (Autriche), qui ont réussi à enchevêtrer des photons avec un nombre quantique orbital allant jusqu'à 300, soit plus de dix fois le record précédent, ont atteint huitième place. Cette découverte n'a qu'une issue théorique, mais aussi pratique - de tels photons « intriqués » peuvent devenir porteurs d'informations dans les ordinateurs quantiques et les systèmes de codage de communication optique, ainsi que dans la télédétection.

Au neuvième place obtenu à un groupe de physiciens dirigé par Daniel Stancil de l'Université de Caroline du Nord (États-Unis). Les scientifiques ont travaillé avec le faisceau de neutrinos NuMI du National Accelerator Laboratory. Détecteur Fermi et MINERvA. En conséquence, ils ont réussi à transmettre des informations à l'aide de neutrinos sur plus d'un kilomètre. Bien que le taux de transmission était faible (0,1 b / s), le message a été reçu presque sans erreur, ce qui confirme la possibilité fondamentale d'une communication basée sur les neutrinos, qui peut être utilisée lors de la communication avec des astronautes non seulement sur une planète voisine, mais même dans une autre galaxie. De plus, cela ouvre de grandes perspectives pour le balayage des neutrinos de la Terre - nouvelle technologie la prospection de minéraux, ainsi que pour la détection des tremblements de terre et de l'activité volcanique dans les premiers stades.

Constantin Sergueïevitch Novoselov

Jeu Andrey Konstantinovitch

Propriétés du graphène

Au contact

- Le plus fin : ~ 0,1 nm 1 couche atomique)

- Le plus léger : 2 700 mètres carrés par gramme ;

- Le plus fort : (les liaisons chimiques sp2 sont plus fortes que les liaisons sp3 dans le diamant !)

- Densité de courant maximale : un million de fois celle du cuivre

- Enregistrez la conductivité thermique

- Mobilité record : des centaines de milliers de cm2 / (V s)

- Libre parcours maximum à T = 300K : environ micron

- Concentration d'électrons ou de trous induits par la porte jusqu'à 1014 cm-2

PROPRIÉTÉS PHYSIQUES INSOLITE DES TRANSPORTEURS EN GRAPHÈNE

1. Dans le graphène, le porteur n'a pas de masse ! (dynamique pseudo-relativiste)

2. Le taux de porteurs dans le graphène est constant

3. L'amplitude de la quantité de mouvement du porteur dans le graphène n'est pas liée à la vitesse, mais uniquement à ses énergies (comme un photon)

Planète Éris

Observatoire Palomar

Mike marron

Contrôler les prothèses à l'aide de signaux cérébraux

Pierpaolo Petruziello

- Gros nommé en raison de sa taille : la longueur de l'anneau principal de l'accélérateur est de 26 659 m ;

- Hadronny- du fait qu'il accélère les hadrons, c'est-à-dire les particules constituées de quarks ;

- Collisionneur(français collide - to collide) - en raison du fait que les faisceaux de particules sont accélérés dans directions opposées et se heurtent à des points de collision spéciaux.

Lyndon Evans - scientifique britannique, chef du projet Large Hadron Collider.

Né en 1945, Aberdeer

Pourquoi les physiciens ont-ils besoin d'un LHC ?

Vérifier le mécanisme de l'origine de la masse dans les particules élémentaires.

Particule élémentaire

Maintenant c'est dur pour elle de bouger (d'accélérer)

Champ de Higgs

Physicien théoricien anglais, membre de la Royal Society of Edinburgh, membre de la Royal Society of London, actuellement professeur à la retraite (émérite) à l'Université d'Édimbourg. A étudié au King's College de Londres.

Peter Higgs

- http://ria.ru/spravka/2010005/282481792.html#ixzz2LGC3zTjv

- http://www.ng.ru/science/2012-12-29/9_bozon.html

- http:// maxpark.com/community/4057/content/1395754

- http:// itnews.com.ua/47494.html

- http:// elementy.ru/news?theme=21093

Vice-président de l'Académie des sciences de Russie Zh. ALFEROV, directeur de l'Institut physico-technique A. F. Ioffe (Saint-Pétersbourg)

En janvier 2000, la conférence "Les sciences naturelles russes au seuil du troisième millénaire" s'est tenue à Saint-Pétersbourg, organisée par l'administration de la ville et le Programme international d'éducation Soros dans le domaine des sciences exactes (ICCEP). La conférence, organisée spécifiquement pour les enseignants des écoles secondaires - le nombre de ces conférences tenues sur cinq ans dans 80 villes de Russie, s'élève à près de quatre cents (!) biologie, écoutez l'opinion de scientifiques de renom sur ce qui a été accompli au cours du siècle dernier et sur les voies d'une éventuelle percée à l'avenir. Et ce qu'il a entendu - à raconter aux étudiants.

S'exprimant à l'ouverture de la conférence à Smolny avec un discours de bienvenue au nom de l'Académie des sciences de Russie, son vice-président Zh. I. Alferov a déclaré qu'à son avis, « l'avenir de la Russie ne sera pas déterminé par Dieu et non par la foi en Dieu, non par la foi dans le président et sa bonne volonté, mais le potentiel scientifique du pays, le développement de la science et de l'éducation. » A cet égard, l'aide apportée par le philanthrope américain J. Soros science russe et l'éducation dans les moments difficiles pour eux, il est difficile de surestimer. Et l'essentiel n'est pas dans le montant dépensé au cours des six années d'existence du programme ICCEP sur certaines bourses, mais dans le fait que ces bourses ont été attribuées non seulement (ou plutôt, pas tellement même) à des scientifiques exceptionnels pour mener des recherches prometteuses, mais c'est avant tout le tour des professeurs d'université, des professeurs des écoles d'enseignement général, des lycées, des étudiants diplômés, des étudiants - en un mot, ceux dont elle dépend pour que l'intérêt pour la science ne se tarisse pas, pour que "le la connexion des temps n'est pas interrompue." "Et j'espère", a conclu Zhores Ivanovich Alferov, "que notre jeunesse talentueuse du 21e siècle fonctionnera dans l'écrasante majorité des cas dans notre pays".

Nous présentons à votre attention une conférence de l'académicien Zh. I. Alferov, membre du comité de rédaction de la revue "Science and Life", prononcée dans le cadre de la conférence Soros à Saint-Pétersbourg. Il donne un aperçu des réalisations de la physique - la principale science du siècle sortant, et évalue ses perspectives pour le siècle prochain.

Il est extrêmement difficile pour un chercheur en activité, et très probablement simplement au-delà du pouvoir, de prédire à quoi ressemblera tout un domaine scientifique au siècle prochain.

C'est plus pratique pour les écrivains de science-fiction de le faire, et beaucoup d'entre nous ont grandi avec les merveilleux romans de Jules Verne. Le scientifique est chargé d'une charge de connaissances réelles et concrètes, qui ne lui permettent pas de faire des prédictions très audacieuses. Bien qu'à un moment donné, Albert Einstein ait expliqué comment les découvertes majeures sont faites. Il a dit que la grande majorité des gens savent que c'est impossible. Puis il y a une personne qui ne sait pas, alors il fait une découverte.

Par conséquent, je consacrerai l'essentiel de mon cours à ce qui s'est passé en physique au cours du XXe siècle ou presque, mais dans le domaine dans lequel je travaille moi-même, je me permettrai quelques extrapolations.

Le vingtième siècle est appelé le siècle des guerres et des révolutions sociales, ce qui est tout à fait juste, et la Russie a reçu ici, comme on dit, en totalité, plus que beaucoup d'autres pays. Mais en même temps, le 20e siècle est aussi appelé l'âge de la physique, et c'est également correct. Mais je l'appellerais l'âge de la physique quantique, puisque c'est la physique quantique qui a déterminé le visage du siècle sortant.

Récemment, le magazine Time a mené une enquête pour savoir quels habitants de la planète peuvent être reconnus comme personnifiant le 20e siècle, et le titre d'homme du siècle avec un avantage écrasant a été attribué à Albert Einstein - le principal créateur (en termes d'individus) de la physique quantique.

Mais en parlant du fait que notre siècle est un siècle de physique quantique, nous devons comprendre que cela ne s'est pas produit par hasard et que des changements révolutionnaires dans les sciences naturelles se sont formés dans la seconde moitié du XIXe siècle et ont été associés, comme toujours, à les activités pratiques de l'homme. En général, l'ensemble science moderne relativement jeune : il a environ trois cents ans, car les fondateurs des sciences naturelles modernes, la physique moderne peuvent être considérés comme Isaac Newton, Galileo Galilei et René Descartes. ils ont formé mécanique classique et la physique classique.

V fin XIX siècle grâce au progrès technique - et surtout à la diffusion de l'éclairage électrique et au développement de la technologie de l'éclairage - une crise des sciences naturelles est survenue - il était nécessaire de justifier clairement les caractéristiques des spectres de rayonnement des corps chauffés. Dans l'ensemble, la physique quantique moderne est née de l'étude de ces caractéristiques.

En 1900, Max Planck, qui adhère fermement à la position de la physique classique et ne veut pas la quitter, propose l'idée d'un quantum pour expliquer précisément les spectres d'émission.

Soit dit en passant, je suis fier d'avoir consacré près de 50 ans de ma vie à travailler dans l'une des institutions scientifiques les plus remarquables de Saint-Pétersbourg, de Russie et du monde - l'Institut de physique et de technologie Abram Fedorovich Ioffe. Mais une telle combinaison - l'Institut de physique et de technologie, pour autant que je sache, est apparu pour la première fois en Allemagne dans les années 80 du siècle dernier, lorsque Werner Siemens, le fondateur de la célèbre entreprise du même nom, a fondé un institut à Berlin , qui se composait de deux départements : physique et technique ; le physique était engagé dans la recherche fondamentale et le technique - dans l'amélioration des lampes à incandescence. Et dans cet institut, beaucoup a été fait pour l'émergence et la justification de la théorie quantique.

Bien sûr, le dernier mot est venu d'Albert Einstein, qui a proposé en 1905 une explication quantique de l'effet photoélectrique. C'est pour la théorie quantique de l'effet photoélectrique, et non pour la théorie de la relativité, qu'il reçut le prix Nobel de physique en 1922. Car ce travail d'A. Einstein a joué un rôle clé dans la formation de la théorie quantique.

De plus, je devrais citer un certain nombre de noms brillants auxquels nous devons non seulement la formation de la physique quantique, mais aussi la compréhension moderne phénomènes physiques: Paul Dirac, Werner Heisenberg, Maurice de Broglie, Niels Bohr, Lev Davidovich Landau et bien d'autres. Après avoir nommé ces noms, je tiens à souligner que la physique quantique à son âge d'or - les années 1920-1930 - a formé non seulement la théorie physique moderne, mais aussi la vision scientifique moderne du monde des personnes engagées dans les sciences naturelles. Ce sont les méthodes physiques de recherche, l'approche physique qui ont contribué à l'essor et au développement de la chimie et de la biologie.

Et maintenant je voudrais m'attarder sur les découvertes - purement expérimentales - basées sur la théorie quantique, qui, de mon point de vue, ont non seulement déterminé le Le progrès technique dans la seconde moitié du 20e siècle, ayant expliqué de nombreuses choses en physique d'une manière nouvelle, mais aussi conduit à des changements sociaux à grande échelle et largement prédéterminé le développement moderne des pays avancés et de la quasi-totalité de la population du globe.

Et la première de ces trois découvertes en physique, j'appellerais la découverte de la fission de l'uranium sous l'influence de l'irradiation neutronique, faite par O. Hahn et F. Strassmann en 1938.

En général, les premières décennies du XXe siècle (j'insiste sur l'expérimentation) ont été marquées principalement par des travaux dans le domaine de la physique nucléaire, des recherches sur la radioactivité et la création d'une théorie moderne du noyau atomique. Mais la découverte de la fission de l'uranium était prévue, je dirais même attendue, et bien plus que la découverte de la supraconductivité à haute température qui a eu lieu dans les années 1980, et a été estimée presque immédiatement. Ici, à Leningrad, il a été apprécié par deux physiciens soviétiques exceptionnels qui ont joué un rôle énorme à la fois dans le développement de la physique fondamentale et dans notre projet atomique : Yakov Borisovich Zeldovich et Yuliy Borisovich Khariton, qui ont effectué un travail brillant sur le calcul des réactions en chaîne basées sur fission de l'uranium.

Vous savez qu'en 1939, le physicien hongrois Leo Szilard, qui vivait alors aux États-Unis, persuada Albert Einstein de signer une lettre au président F. Roosevelt, dans laquelle il exprimait un avertissement selon lequel les nazis pourraient être les premiers à fabriquer une bombe atomique. À cet égard, une demande insistante a été exprimée pour l'attribution de leur propre recherche atomique. Peu de temps après, une telle décision a été prise et le célèbre projet Manhattan a commencé.

Dans notre pays, l'un des initiateurs du projet atomique soviétique était Georgy Nikolaevich Flerov, un étudiant diplômé d'Igor Vasilievich Kurchatov à l'Institut physico-technique. À cette époque, il a été enrôlé dans l'armée, mais à chaque occasion, il a continué à parcourir les revues scientifiques. Constatant que les publications liées aux sujets atomiques y avaient disparu (ce qui signifiait que les travaux dans ce domaine étaient classés), il commença à bombarder les hautes autorités, dont Staline, de lettres, prouvant la nécessité du développement du projet atomique soviétique.

En étudiant les documents déclassifiés et publiés de 1938-1943, les transcriptions de réunions, les discours, vous comprenez quels merveilleux physiciens nous avions: Abram Fedorovich Ioffe, Igor Vasilievich Kurchatov, Sergei Ivanovich Vavilov. J'admire particulièrement A.F. Ioffe et S.I. Vavilov, car ils ont travaillé dans d'autres domaines (comme vous le savez, A.F. Ioffe est le fondateur de la science des semi-conducteurs, S.I. loin d'eux. Mais ils étaient bien versés dans ces questions !

Aujourd'hui, de nombreuses publications sont parues, affirmant que nos scientifiques n'avaient prétendument rien à faire - disent-ils, l'intelligence a tout apporté. Oui, bien sûr, le renseignement a fait son travail (et, surtout, pour des raisons idéologiques, Klaus Fuchs). Mais en réalité, aucune intelligence ne pourrait nous fournir des armes atomiques et résoudre le problème atomique. Les armes atomiques ont été créées en URSS en raison du fait que déjà dans les années 1920-1930

Pendant des années, nous avons eu notre propre école nationale de physiciens, qui a vu le jour principalement grâce à AF Ioffe et au soi-disant «jardin d'enfants du pape Ioffe», qui a été formé à l'Institut physico-technique. Le début remonte à 1919, lorsque Abram Fedorovich, avec Stepan Prokofievich Timoshenko, a fondé le département de physique et de mécanique de l'Institut polytechnique. C'était complètement nouveau pour l'époque. établissement d'enseignement, qui s'est fixé comme objectif la formation de physiciens ayant une compréhension des problèmes d'ingénierie et la formation d'ingénieurs ayant une base physique et mathématique très approfondie. C'est ce "jardin d'enfants de papa Ioffe", d'où a émergé toute une garde de trois fois Héros du travail socialiste, des dizaines d'académiciens, et résolu à l'avenir pour notre pays à la fois atomique et semi-conducteur, et bien d'autres problèmes.

Bien sûr, aujourd'hui, surtout après la catastrophe de Tchernobyl, on parle beaucoup des dangers de l'utilisation de l'énergie atomique. Et dans un certain nombre de pays, des mesures sont prises pour réduire l'énergie nucléaire. Bien que je ne sois pas un expert dans ce domaine, mais d'après mes conversations, mes lectures d'ouvrages pertinents et mes discussions sur ce problème à un niveau scientifique très représentatif, j'en suis venu à croire qu'au XXIe siècle, l'énergie nucléaire sera la principale source d'énergie non seulement dans notre pays, mais partout dans le monde. Et surtout parce que les réserves d'énergies fossiles s'épuisent. L'ingénierie nucléaire moderne est beaucoup plus respectueuse de l'environnement que les centrales au charbon ou même au fioul. Dans le domaine de la technologie des réacteurs, nous avons de très bons développements, et je suis sûr qu'il en sera ainsi, car l'ingénierie de l'énergie thermonucléaire est encore assez loin d'être réalisée. À cet égard, un tel cas est remarquable. Lorsque le chef du programme thermonucléaire britannique, Sir John Cockcroft, lauréat du prix Nobel, a été interrogé par les journalistes quand la mise en œuvre industrielle de l'énergie thermonucléaire peut être attendue, il a répondu : « Dans vingt ans. Sept ans plus tard, lors d'une conférence similaire, on posa à nouveau à Cockcroft la même question, qui fut suivie de la réponse précédente : « Dans vingt ans. Et quand les journalistes surpris se sont exclamés : « Mais, excusez-moi, vous l'avez dit aussi il y a sept ans !

Aujourd'hui, ce point de vue a changé. Le projet international du réacteur thermonucléaire ITER bat son plein et avec notre participation, cependant, le début de l'utilisation industrielle de l'énergie thermonucléaire remonte au milieu du XXIe siècle. C'est-à-dire que ce ne sera pas dans vingt ans, mais en tout cinquante ans. Les espoirs peuvent donc être placés dans le nucléaire. Dieu veuille que dans aucun pays au monde la découverte d'O. Gahn et F. Strassmann ne soit utilisée de la même manière que l'a fait le président américain H. Truman en 1945 lors des bombardements d'Hiroshima et de Nagasaki.

La deuxième découverte majeure de la physique du 20e siècle est, bien sûr, la création d'un transistor.

Il a été fabriqué en 1947 par trois remarquables physiciens américains- John Bardin, Walter Brattain et William Shockley dans le laboratoire de Bell Telephone. La découverte est le résultat du développement rapide de la physique des semi-conducteurs, de la technologie des semi-conducteurs et, surtout, du radar pendant la Seconde Guerre mondiale.

John Bardeen est l'un des plus physiciens éminents XXe siècle, principalement dans le domaine de la physique de la matière condensée, le seul deux fois lauréat du prix Nobel de physique dans l'histoire de la physique dans le même domaine scientifique. Il a reçu le premier prix en 1956, avec W. Brattain et W. Shockley, pour la découverte du transistor, et le second en 1972, avec L. Cooper et J. Schrieffer, pour la théorie de la supraconductivité, qui pour le a donné pour la première fois une explication complète de ce mystérieux phénomène découvert par Geike Kamerling Onnes en 1911 en Hollande.

Niels Bohr et Abram Fedorovich Ioffe. Moscou, 1934.

Le bureau d'Otto Hahn. Deutsches Museum, Munich. Sur une telle table, les premières expériences sur l'étude des substances radioactives ont été réalisées.

Séminaire d'A.F. Ioffe, 1916. Assis (de gauche à droite) : P. I. Lukirsky, A. F. Ioffe, N. N. Semenov ; debout : J. G. Dorfman, J. R. Schmidt, K. F. Nesturkh, N. I. Dobronravov, M. V. Kirpicheva, J. I. Frenkel, A. P. Yushchenko, I. K. Bobr et P. L. Kapitsa.

1947 : John Bardeen, William Shockley et Walter Brattain examinent leur premier transistor au microscope (ci-dessus).

Réacteur nucléaire de recherche en série conçu au sein de l'association de production Atomenergoexport. années 1980.

Les premiers ordinateurs, apparus à la fin des années 40, fonctionnaient sur des tubes radio, qui étaient très chauds et avaient tendance à griller de manière inattendue.

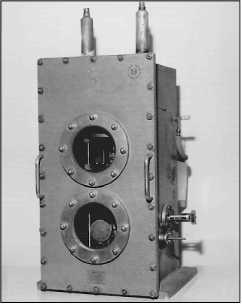

Générateur quantique moléculaire (maser). 1955 année. Musée d'histoire de l'Institut d'État de génie physique de Moscou (Université technique).

I. E. Tamm, F. Dyson, R. Peierls et V. L. Ginzburg sur Conférence internationale sur la physique des particules élémentaires. Moscou, 1956.

Niels Bohr et Lev Davidovich Landau au "Festival Archimède" à l'Université d'État de Moscou, 1961.

Les académiciens Ya. B. Zel'dovich, Yu. B. Khariton et NN Semenov.

Le Présidium de l'Académie des sciences de l'URSS a décerné à John Bardeen sa plus haute distinction - la médaille MV Lomonosov. Et John Bardeen, s'exprimant lors de la dernière réunion de la Conférence internationale sur la physique des semi-conducteurs en 1960, a déclaré: "La science est internationale, la physique est internationale, il n'y a pas de physique nationale. en Allemagne, Ioffe et Frenkel - en URSS ". Le 23 décembre 1947, le premier amplificateur à transistor a été présenté et une nouvelle ère de l'électronique a commencé. Et un peu plus tard, le domaine scientifique et technique le plus large est apparu, ce qui a conduit à d'énormes changements sociaux dans le monde.

Il y avait des raisons très précises au fait que le transistor soit né aux États-Unis d'Amérique, mais il ne faut pas oublier qu'une grande contribution à cette découverte exceptionnelle l'humanité a été introduite par les physiciens de notre pays.

Soit dit en passant, ces travaux ont commencé de nombreuses années avant la guerre, et les travaux d'Oleg Vasilyevich Losev, un inventeur de génie du laboratoire radio de Nijni Novgorod, décédé prématurément, ont beaucoup contribué à leur développement. Parmi les autres découvertes de Losev figurait la création d'un amplificateur à cristal "Kristadin Losev", mais, comme on dit, un œuf est cher au jour du Christ. Lorsque les découvertes sont faites trop tôt et que l'état de l'art n'est pas prêt pour cela, elles ne "passent généralement pas" et sont oubliées.

Mais, par exemple, un tel fait est également intéressant. Melvin Kelly, vice-président de la plus grande compagnie de téléphone Bell, formant un groupe pour effectuer des recherches en 1945 sur la physique du solide et le développement de nouveaux moyens techniques pour le radar, a formulé sa tâche principale comme un test de théorie quantique pour la matière condensée. Le groupe était exceptionnellement fort. Il comprenait les trois qui ont reçu plus tard le prix Nobel, ainsi que l'éminent physicien Gerald Pearson et de nombreux ingénieurs en électrochimie, mécaniciens et techniciens de laboratoire très qualifiés. Les employés du groupe ont découvert de nouveaux phénomènes physiques qui sont devenus la base du transistor à effet de champ et du transistor dit bipolaire.

En 1958, le premier circuit intégré a été construit. Il s'agissait d'une plaque constituée d'un monocristal de silicium d'une superficie de plusieurs centimètres carrés, sur laquelle deux transistors et une chaîne RC de transistors ont été obtenus. Un microprocesseur moderne avec un côté de, disons, 1,8 centimètre a 8 millions de transistors. Si les dimensions des premiers transistors étaient calculées en fractions de millimètre, alors les méthodes photolithographiques permettent aujourd'hui d'obtenir des dimensions de 0,35 micron. C'est un niveau technologique moderne. Dans un avenir très proche, une transition vers 0,18 micron est attendue et dans 5 à 7 ans - vers 0,1 micron.

Mais autre chose est intéressant. D'une part, on peut dire qu'il s'agit d'un énorme progrès technique, mais d'autre part, purement physique, aucun phénomène nouveau n'y est apparu : le même transistor à effet de champ et bipolaire et les mêmes effets qui ont été découverts à la fin années 1940. Cependant, c'est cette technologie, ces découvertes physiques est devenu la base de toute la microélectronique moderne, et la microélectronique moderne a changé le monde.

Je vais juste vous donner un exemple très simple. Jusqu'au début du 20e siècle, les États-Unis d'Amérique étaient un pays agricole. Cela signifie que des quatre principaux groupes de la population active - ceux employés dans l'industrie, agriculture, le secteur des services et dans le domaine de l'informatique (qui comprend les comptables) - le groupe le plus important de travailleurs est celui qui a travaillé dans l'agriculture. Au milieu du siècle, les États-Unis devenaient un pays industriel parce que le groupe le plus important était celui qui travaillait dans l'industrie. Et depuis 1955 environ, les États-Unis sont déjà un pays post-industriel, puisque le groupe le plus important de la population active est celui qui s'occupe d'obtenir et d'utiliser des informations.

Mais voici ce qui est remarquable : en 1970, la taille de ce groupe atteignait 50 % de la population active aux États-Unis, et depuis lors, en 30 ans, sa part est restée pratiquement inchangée. Le nombre de personnes employées dans l'industrie et l'agriculture diminue encore légèrement, le nombre de personnes employées dans le secteur des services augmente, cependant, en pourcentage d'entre elles, le nombre de personnes employées dans l'informatique reste le même. Et cela se produit grâce à la révolution informatique.

Ainsi, la découverte du transistor a entraîné un changement dans la structure sociale de la population, d'abord dans les pays développés, puis progressivement dans tous les autres. C'est la découverte du transistor qui nous donne le droit de parler de l'avènement du temps post-industriel, le temps de la société de l'information.

Eh bien, le troisième événement scientifique mondial du 20e siècle, en quelque sorte lié à la création d'un transistor, est la découverte du principe laser-maser. Et cela a été fait en 1954-1955 pratiquement simultanément par Charles Townes aux États-Unis et Nikolai Gennadievich Basov et Alexander Mikhailovich Prokhorov à l'Institut de physique de l'Académie des sciences de l'URSS.

Si dans mon histoire sur le transistor je n'ai parlé que de la contribution apportée à sa découverte par les scientifiques soviétiques de l'école « Papa Ioffe », alors les collègues américains partagent à juste titre l'honneur de découvrir le principe laser-maser avec nos grands compatriotes. Ceci est démontré de manière éloquente par le fait qu'en 1964, le prix Nobel de physique - et il n'a jamais été décerné aux scientifiques soviétiques et russes avec facilité - en raison de circonstances inévitables, cette fois Townes a dû partager avec Basov et Prokhorov.

Dans l'Encyclopédie américaine sur l'attribution du prix en 1964 à N. G. Basov et A. M. Prokhorov, les paroles du président du Comité Nobel de physique ont été citées. Il a dit que monde scientifique a été choqué d'apprendre que bien connu du monde le scientifique Charles Townes partagea le prix Nobel avec deux Russes inconnus, qui, à l'aide de leurs moyens primitifs, firent la même découverte qu'avec l'équipement moderne de Charles Townes. "Mais", a-t-il conclu, "le travail effectué par des moyens expérimentaux primitifs doit être encouragé tout autant que les découvertes qui sont faites en appuyant sur un bouton sur un équipement moderne et coûteux." Cependant, le président respecté du Comité Nobel avait tort, car les moyens expérimentaux de nos principaux instituts de physique - FIAN et Phystech - à cette époque ne différaient pratiquement pas des moyens similaires des laboratoires occidentaux, y compris américains.

Tout le monde sait que la technologie laser se développe rapidement et est très largement utilisée. Il est devenu un puissant outil technique et technologique en médecine, avec son aide, les opérations les plus complexes, mais déjà tout à fait habituelles, sont effectuées, le soudage et la découpe de matériaux sont effectués. Ce n'est un secret pour personne qu'il existe des armes laser qui peuvent abattre des satellites. Dans le même temps, le laser est aujourd'hui un puissant outil d'information, et les lasers à semi-conducteurs jouent un rôle énorme dans le domaine de l'informatique.

En 1970, les Américains ont créé les premières fibres à faibles pertes, et dans notre laboratoire de Phystech, à cette époque, pour la première fois au monde, sont apparus des lasers à semi-conducteur fonctionnant en mode continu à température ambiante à base d'hétérostructures dites semi-conductrices. . C'est ainsi qu'est née la communication par fibre optique. Ensuite, les lasers à semi-conducteurs ont commencé à être largement utilisés dans les lecteurs laser maintenant connus de tous, où un minuscule laser à semi-conducteurs sert d'aiguille qui enregistre les informations.

Ainsi, d'une part, les lasers, la technologie laser, la physique de la création laser elle-même est un triomphe de la théorie quantique. D'autre part, ce sont des moyens techniques puissants qui, je le répète, ont largement déterminé à la fois le progrès et les changements dans la structure sociale de la société.

Eh bien, à quoi pouvons-nous nous attendre maintenant?

Dans les décennies à venir, apparemment, il n'y a pas lieu de s'attendre à une nouvelle poussée dans l'explication des phénomènes de la nature inanimée - et la physique s'occupe de ce domaine même.

Le fait est qu'une situation révolutionnaire similaire à celle qui a provoqué l'émergence d'une brillante galaxie de scientifiques exceptionnels, les nôtres et étrangers, qui ont créé le la physique quantique... Pour cela, je le répète, il faudrait une crise du leader direction scientifique, et aujourd'hui nous ne voyons pas encore si cela se produit en théorie quantique. Apparemment non.

À une époque, l'un des physiciens britanniques exceptionnels Rudolph Peierls, l'un des participants actifs au projet Manhattan aux États-Unis et à la création d'armes atomiques en Grande-Bretagne, qui a beaucoup travaillé dans notre pays, dans la physique de Leningrad et de Kharkov. Union), parlant de la galaxie dorée des physiciens des années 1920, il m'a dit : - travail de première classe" ... Bien sûr, cela se reflétait dans la plus grande modestie de l'un des physiciens exceptionnels du XXe siècle, mais en même temps, ses paroles reflétaient en quelque sorte la situation qui s'était développée à l'époque de l'âge d'or de la physique.

Une fois, j'ai regardé ce qui était fait à ce moment-là dans notre équipe relativement petite de l'Institut physicotechnique, et j'ai été choqué par l'ampleur de ce qui a été fait. Et cela dans un pays encore ravagé après la guerre civile !

En 1921, Abram Fedorovich Ioffe, Alexei Nikolaevich Krylov et Dmitry Sergeevich Rozhdestvensky se sont rendus à l'étranger pour la première fois après la révolution. Abram Fedorovich a emmené avec lui Pyotr Leonidovich Kapitsa, alors dans un état très grave (sa femme et ses deux jeunes enfants sont décédés en 1919), et il est allé travailler pour E. Rutherford. Et Ioffe lui-même, avec les fonds budgétaires alloués pour ce voyage, a acheté 42 boîtes d'équipements modernes pour Phystech et a souscrit pour près de 50 revues scientifiques... Dieu veuille que vous puissiez maintenant faire des voyages aussi efficaces.

Bien sûr, à notre époque, je le répète, il n'y a pas une telle situation révolutionnaire. Mais néanmoins, des changements intéressants et importants sont susceptibles de se produire. Et surtout dans la physique des hétérostructures dites semi-conductrices, des structures monocristallines, dans lesquelles il y a une transition vers différentes composition chimique substances. Aujourd'hui, le niveau de cette technologie a atteint un état où nous savons vraiment comment "empiler" un atome sur un atome et créer des structures fondamentalement nouvelles. Nous pouvons le dire ainsi : nous fabriquons expérimentalement des objets sur lesquels nous pouvons tester des problèmes pour un manuel de mécanique quantique, en construisant ces objets expérimentaux de diverses manières.

Mais pas seulement ça. Nous créons des systèmes avec une dimension réduite d'un gaz d'électrons, lorsque les électrons sont limités soit dans un plan, soit dans une dimension, dans un fil, ou sont généralement des structures de dimension zéro, ce sont les points dits quantiques, fabriqués par l'homme , atomes artificiels. Nous pouvons modifier leurs propriétés à notre guise. Et à partir de ce domaine, une toute nouvelle génération de composants électroniques verra certainement le jour, ce qui changera radicalement Systèmes d'information déjà parfait aujourd'hui.

Points quantiques, fils quantiques, physique de la matière condensée à dimension quantique - il existe une telle richesse de nouveaux phénomènes physiques, de nouvelles idées physiques que, j'espère, dans 10-20 ans, ce domaine pourra dire qu'il n'a pas seulement changé la technique systèmes d'information, mais nous a aussi donné beaucoup de nouveaux phénomènes physiques.

Il est possible que ce ne soient que des germes très faibles qui apparaissent précisément dans l'étude des hétérostructures semi-conductrices. L'émergence de certaines idées révolutionnaires est également possible. Je pense que la découverte de l'effet hall quantique fractionnaire par Horst L. Stormer, Daniel Tsui et Robert Lochlin, pour lequel ils ont reçu le prix Nobel de physique en 1998, peut être le précurseur de nouvelles idées révolutionnaires sur la matière condensée. physique (voir " Science et Vie " n° 1, 1999 - Ed.). Dans les champs magnétiques forts et les températures très basses, un certain nombre de phénomènes ont été découverts qui ne pouvaient être expliqués qu'en supposant qu'un liquide quantique doit avoir un composant avec une charge fractionnaire. Le fait qu'apparaissent des faits expérimentaux qui nécessitent l'utilisation d'explications similaires et totalement non triviales suggère déjà que tout n'est pas en ordre dans "ce royaume" et que quelque chose de nouveau et d'intéressant peut se produire ici.

On peut dire avec un certain regret que la supraconductivité à haute température, découverte par Alex Müller et Georg Bednorz en 1986, n'a presque rien donné à la pratique et, en général, n'a pas changé significativement nos idées. On peut dire que le grand programme de fusion thermonucléaire contrôlée, qui a donné beaucoup de choses intéressantes pour la physique des plasmas, n'a pas encore trouvé de réelle application pratique. Mais, probablement, quelque chose se passera également dans ces domaines. Mais en ce qui concerne les objets à dimension quantique de la physique de la matière condensée, les fils quantiques et les points quantiques, on peut certainement s'attendre à un changement dans les concepts physiques fondamentaux, et donc à une nouvelle véritable explosion de la science.

Enregistré par N. DOMRINA.

Les scientifiques britanniques Michael Kosterlitz, David Thouless et Duncan Haldane ont reçu le prix Nobel de physique « pour les découvertes théoriques des transitions de phase topologiques et des phases topologiques de la matière ». Les mots « découvertes théoriques » soulèvent des doutes quant au fait que leurs travaux auront une application pratique ou qu'ils pourront affecter nos vies à l'avenir. Mais tout peut s'avérer être tout le contraire.

Pour comprendre le potentiel de cette découverte, il sera utile d'acquérir une compréhension de la théorie. La plupart des gens savent qu'il y a un noyau à l'intérieur d'un atome et que les électrons tournent autour de lui. Cela correspond à différents niveaux d'énergie. Lorsque les atomes se regroupent et créent une sorte de matière, tous les niveaux d'énergie de chaque atome se combinent pour créer des zones d'électrons. Chaque bande d'énergie d'électrons a de la place pour un certain nombre d'électrons. Et entre chaque zone, il y a des espaces dans lesquels les électrons ne peuvent pas se déplacer.

Si le matériel est soumis charge électrique(le flux d'électrons supplémentaires), sa conductivité est déterminée par le fait que la zone d'électrons avec le plus d'énergie a de la place pour de nouveaux électrons. Si c'est le cas, le matériau se comportera comme un conducteur. Sinon, une énergie supplémentaire est nécessaire pour pousser le flux d'électrons dans une nouvelle zone vide. En conséquence, ce matériau se comportera comme un isolant. La conductivité est essentielle à l'électronique car les composants tels que les conducteurs, les semi-conducteurs et les diélectriques sont au cœur de ses produits.

Le contexte

Des trous noirs de laboratoire ?

Nautile 16.09.2016L'astrophysique en laboratoire

ScienceAlerte 31.08.2016La polémique sur la physique du temps

Magazine Quanta 25.07.2016Les prédictions de Kosterlitz, Thouless et Haldane dans les années 1970 et 1980 sont que certains matériaux n'obéissent pas à cette règle. Certains autres théoriciens soutiennent également leur point de vue. Ils ont suggéré qu'au lieu des écarts entre les zones d'électrons, où ils ne peuvent pas être, il existe un niveau d'énergie spécial dans lequel des choses différentes et très inattendues sont possibles.

Cette propriété n'existe qu'en surface et sur les bords de tels matériaux et est extrêmement stable. Dans une certaine mesure, cela dépend aussi de la forme du matériau. En physique, cela s'appelle la topologie. Dans un matériau en forme de sphère ou, par exemple, d'œuf, ces propriétés ou caractéristiques sont identiques, mais dans un beignet, elles diffèrent en raison d'un trou au milieu. Les premières mesures de ces caractéristiques ont été faites par le courant le long de la limite de la feuille plate.

Les propriétés de tels matériaux topologiques peuvent être extrêmement utiles. Par exemple, un courant électrique peut circuler à leur surface sans aucune résistance, même lorsque l'appareil est légèrement endommagé. Les supraconducteurs le font même sans propriétés topologiques, mais ils ne peuvent fonctionner qu'à très basse température. C'est-à-dire qu'une grande quantité d'énergie ne peut être utilisée que dans un conducteur refroidi. Les matériaux topologiques peuvent faire la même chose à des températures plus élevées.

Cela a des implications importantes pour le travail assisté par ordinateur. La plupart de l'énergie consommée par les ordinateurs aujourd'hui va aux ventilateurs pour réduire les températures causées par la résistance dans les circuits. En éliminant ce problème de chauffage, les ordinateurs peuvent être beaucoup plus économes en énergie. Par exemple, cela conduira à une réduction significative des émissions de carbone. De plus, il sera possible de fabriquer des batteries avec une durée de vie beaucoup plus longue. Les scientifiques ont déjà commencé des expériences avec des matériaux topologiques tels que le tellurure de cadmium et le tellurure de mercure pour mettre la théorie en pratique.

De plus, des avancées majeures sont possibles dans le domaine de la l'informatique quantique... Les ordinateurs classiques codent les données soit en appliquant une tension au microcircuit ou non. En conséquence, l'ordinateur interprète cela comme 0 ou 1 pour chaque bit d'information. En rassemblant ces bits, nous créons des données plus complexes. C'est ainsi que fonctionne un système binaire.

En informatique quantique, nous livrons des informations aux électrons, pas aux microcircuits. Les niveaux d'énergie de ces électrons correspondent à des zéros ou à des uns comme dans les ordinateurs classiques, mais dans mécanique quantique c'est possible en même temps. Sans entrer dans trop de théorie, disons simplement que cela donne aux ordinateurs la possibilité de traiter de très grandes quantités de données en parallèle, ce qui les rend beaucoup plus rapides.

Des entreprises comme Google et IBM mènent des recherches pour essayer de comprendre comment utiliser la manipulation électronique pour créer des ordinateurs quantiques beaucoup plus puissants que les ordinateurs classiques. Mais il y a un obstacle majeur en cours de route. De tels ordinateurs sont mal protégés des "interférences sonores" environnantes. Si un ordinateur classique est capable de gérer le bruit, alors un ordinateur quantique peut produire une grande variété d'erreurs dues à des trames instables, à des champs électriques aléatoires ou à des molécules d'air qui pénètrent dans le processeur même s'il est maintenu sous vide. C'est la principale raison pour laquelle nous n'utilisons pas encore d'ordinateurs quantiques dans la vie de tous les jours.

Une solution possible consiste à stocker l'information non pas dans un, mais dans plusieurs électrons, car les interférences affectent généralement les processeurs quantiques au niveau des particules individuelles. Supposons que nous ayons cinq électrons qui stockent ensemble la même information. Par conséquent, s'il est stocké correctement dans la plupart des électrons, les interférences affectant un électron individuel ne gâcheront pas l'ensemble du système.

Les scientifiques expérimentent ce que l'on appelle le vote majoritaire, mais l'ingénierie topologique peut offrir une solution plus simple. Tout comme les supraconducteurs topologiques peuvent conduire le flux d'électricité suffisamment bien pour être exempts de résistance, les ordinateurs quantiques topologiques peuvent être suffisamment robustes et immunisés contre les interférences. Cela pourrait grandement contribuer à faire de l'informatique quantique une réalité. Des scientifiques américains y travaillent activement.

Futur

Cela peut prendre 10 à 30 ans avant que les scientifiques apprennent à manipuler suffisamment bien les électrons pour que l'informatique quantique devienne possible. Mais des opportunités assez intéressantes se dessinent déjà. Par exemple, de tels ordinateurs peuvent simuler la formation de molécules, ce qui est un défi quantitatif pour les ordinateurs traditionnels d'aujourd'hui. Cela a le potentiel de révolutionner la production de médicaments, car nous pourrons prédire ce qui se passera dans le corps au cours des processus chimiques.

Voici un autre exemple. Un ordinateur quantique peut transformer l'intelligence artificielle en réalité. Les machines quantiques apprennent mieux que les ordinateurs classiques. Cela est en partie dû au fait que des algorithmes beaucoup plus intelligents peuvent y être intégrés. La solution au secret de l'intelligence artificielle deviendra un changement qualitatif dans l'existence de l'humanité - cependant, on ne le sait pas, pour le meilleur ou pour le pire.

En bref, les prédictions de Kosterlitz, Thouless et Haldane pourraient révolutionner la technologie informatique au 21e siècle. Si le comité Nobel reconnaissait l'importance de son travail aujourd'hui, alors nous le remercierons sûrement pour de nombreuses années à venir.